自分:サポートベクターマシーンで「分類」するのと、「回帰」するのは、何が違うの?何が同じ?

ChatGPT 4o:

サポートベクターマシン(Support Vector Machine, SVM)で「分類(classification)」と「回帰(regression)」を行う場合、その考え方のコアは共通していますが、目的と損失関数、マージンの定義などが異なります。

✅ 共通点(SVMの基本思想)

| 項目 | 内容 |

|---|---|

| カーネルトリックが使える | 線形でない問題にも対応可(RBFカーネル、ポリカーネルなど) |

| マージンの最大化 | どちらも「予測の余裕(マージン)」を最大化しようとする点で共通 |

| 最適化問題を解く | 目的関数を最小化するための凸最適化問題として定式化 |

| 正則化項(C)で過学習を防ぐ | 複雑さと誤差のトレードオフを制御 |

| サポートベクターが学習の核 | 重要な訓練データ点だけがモデルの決定に寄与する |

❌ 相違点

| 観点 | 分類(SVC) | 回帰(SVR) |

|---|---|---|

| 目的 | クラスラベルを予測(例:0 or 1) | 実数値を予測(例:価格、温度) |

| 出力 | 離散ラベル(分類境界のどちら側にあるか) | 連続値(近似関数) |

| マージンの定義 | 正と負のクラスの間に最大マージンの境界を作る | 許容誤差ε内に収まるようなεチューブを構築 |

| 損失関数 | ヒンジ損失(margin-based) | ε-insensitive 損失(誤差がεより大きいとペナルティ) |

| 学習目標 | クラスを明確に分離 | できるだけ滑らかで誤差の小さい回帰曲線を作る |

🔍 直感的なたとえ

- 分類SVMは、「赤と青の点をできるだけ離して、真ん中に境界線を引く」作業。

- 回帰SVMは、「点群に滑らかな線を当てはめるけど、多少の誤差(ε)は許す」というイメージ。

💡どちらを使うべきか?

| タスク例 | モデル |

|---|---|

| メールがスパムか否か | 分類(SVC) |

| 気温を予測したい | 回帰(SVR) |

| がんの有無を予測 | 分類 |

| 売上高を予測 | 回帰 |

分類と回帰の類似について

「確率を知りたいのか、クラスを決めたいのか」によって、分類と回帰の境界はあいまいになることがあります。

✅ イベントが起こる「確率」を知りたい:回帰的アプローチ

たとえば:

- 病気にかかる確率 →

P(y=1 | x) - 顧客が購入する確率 →

P(purchase=1 | features)

このような場合、出力が0〜1の連続値で、これは「確率」のように解釈されます。

SVMではこれに直接対応するのはやや苦手(理由は後述)ですが、ロジスティック回帰などはこのタスクに適しています。

✅ 確率にしきい値(カットオフ)を設けて、「分類」する:分類的アプローチ

確率が0.5を超えたら陽性(positive)、それ以下なら陰性(negative)とする、という方法:

if P(y=1 | x) ≥ 0.5 → 1(陽性)

else → 0(陰性)

これは、実質的には分類タスクですが、内部で回帰モデル(確率予測モデル)を使っている点で回帰的な分類とも言えます。

❗SVMの場合はどうか?

SVMはもともと「境界を引くこと(マージン最大化)」が目的なので、確率を出力しません(出力は +1 または -1)。

ただし、SVMでも「確率推定付きSVM(Platt Scalingなど)」を使えば、0〜1の確率を後処理で得ることができます:

from sklearn.svm import SVC

model = SVC(probability=True)

model.fit(X_train, y_train)

probs = model.predict_proba(X_test)

このようにすれば、「SVMで回帰的に確率を求め → カットオフで分類」という操作も可能です。

💡まとめ

| 欲しいもの | 適したモデル | コメント |

|---|---|---|

| クラス(0 or 1) | 分類(SVM, ロジスティック回帰など) | 出力は離散的 |

| 確率(0.0〜1.0) | 回帰的分類(ロジスティック回帰、Platt SVM) | 出力は連続、閾値で分類も可能 |

| 実数値(売上、価格など) | 回帰(SVRなど) | 数量予測 |

SVCによる分類と回帰の実例

-

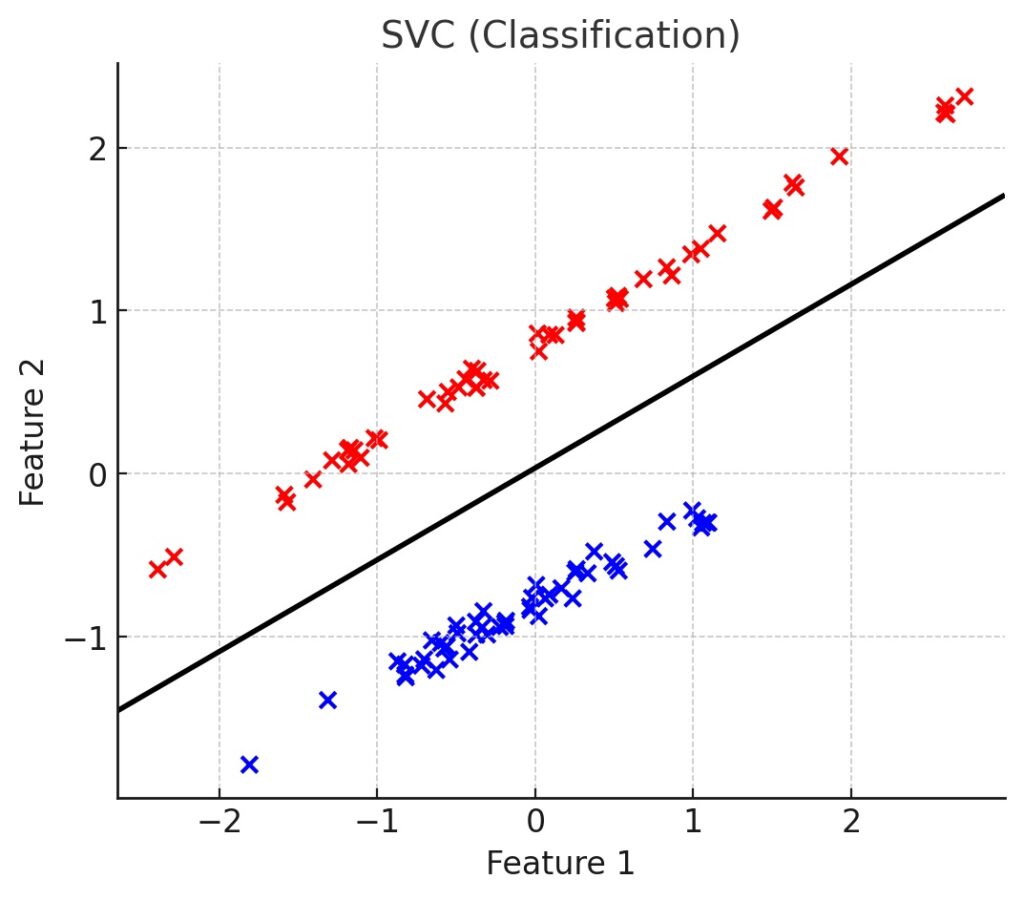

上の図(SVC – Classification):

-

赤と青の点は2クラスのデータ。

-

黒い線がSVMによる分類境界(decision boundary)。

-

-

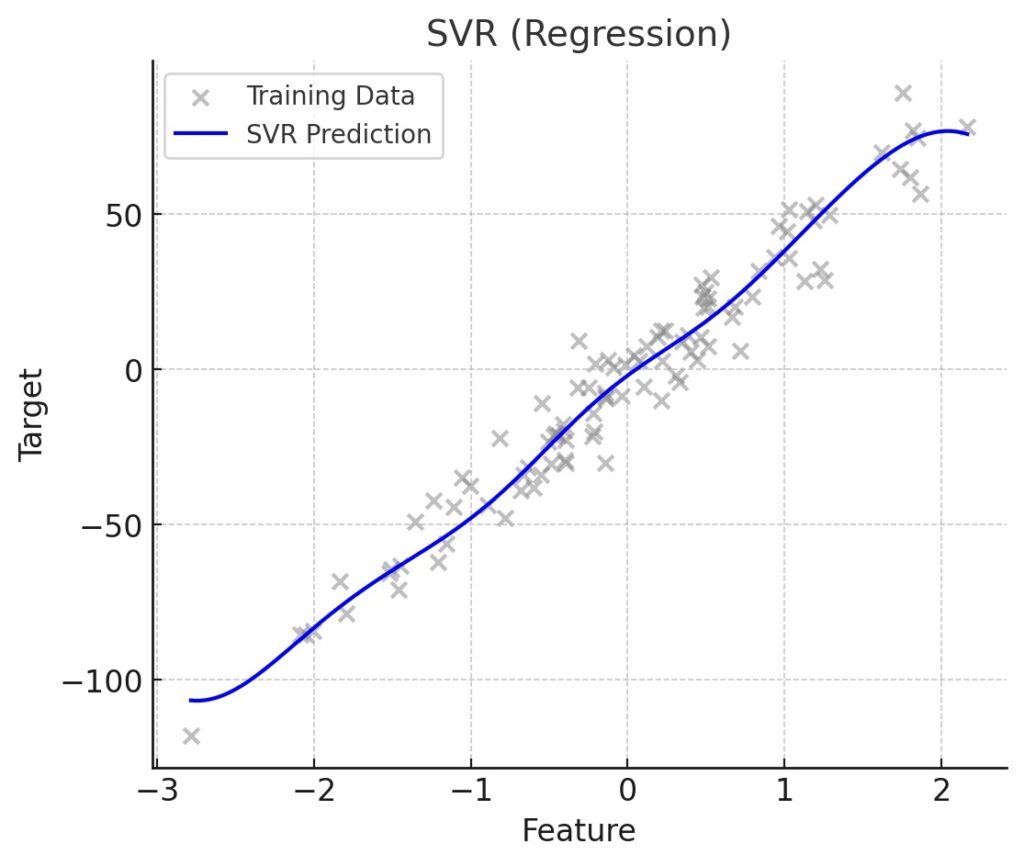

下の図(SVR – Regression):

-

グレーの点は回帰用の訓練データ。

-

青い曲線がSVRによる予測関数(予測線)。

-

SVCは「2クラスを分ける線」を、SVRは「実数値を予測する滑らかな線」を、それぞれ学習するという違いが視覚的に理解できます。

SVMを分類(SVC)として使うか、回帰(SVR)として使うかは、以下の2点に依存します:

✅ 1. データの「目的」

| 目的 | 適したモデル |

|---|---|

| あるカテゴリに属するか知りたい(Yes/No, A/Bなど) | SVC(分類) |

| 実数の値を予測したい(価格、温度、スコアなど) | SVR(回帰) |

| 確率が知りたい & クラスも判定したい | ロジスティック回帰 or SVC + Platt scaling |

✅ 2. データの「性質・分布」

| データの形 | 向いているSVMの使い方 |

|---|---|

| ラベルが2値または多クラス分類 | SVC |

| 出力が連続値(数値) | SVR |

| 出力が0〜1に分布し、確率っぽい解釈がされる | SVRでもSVCでも可(閾値次第) |

💡つまり:

- 分類か回帰かを選ぶのは、「データの出力変数(目的変数)が何を意味しているか」による。

- そしてその変数に対して、**どういう出力が欲しいか(Yes/No? 実数? 確率?)**によって、モデル(SVCかSVRか)を決めます。

🔁 ボーダーラインなケース(応用的な選択)

- クレジットカード不正利用の検知:

- 最終的には「不正 or 正常」の2クラス → 分類

- でも、不正である「確率」も知りたい → 分類+確率出力(SVC+Platt)

- 売上予測:

- 「今月いくら売れる?」→ 回帰(SVR)

- 「売上が10万円を超えるかどうか?」→ 分類(SVC)

✳補足:

SVMはもともとマージン最大化の考えに基づいたアルゴリズムなので、分類に最も適しています。ただし、回帰にも応用できるように設計されており、その場合はマージンではなく「εチューブ(誤差の許容範囲)」という別の考えを使います。